Musik trifft Informatik

Inhaltsbasierte Suche im Carus-Audiokatalog

Wenn man zufällig einen kurzen Ausschnitt einer Musikaufnahme hört – ob im Fernsehen, Radio oder als Hintergrundmusik eines Videos – dann fragt man sich oft um welches Musikstück es sich hier handeln könnte. Um Musiktitel und Komponist herauszufinden, sind in diesem Szenario automatisierte Suchtechniken hilfreich, mittels derer man den Musikausschnitt mit Referenzaufnahmen akustisch vergleichen und nach ähnlichen Mustern durchsuchen kann. In dem von der Deutsche Forschungsgemeinschaft (DFG) geförderten Projekt „Automatisierte Methoden und Werkzeuge zur Analyse und Strukturierung von Chormusik“ haben Wissenschaftlerinnen und Wissenschaftler der Universität Erlangen in Kooperation mit dem Carus-Verlag daran geforscht, wie man große digitale Musikdatenbestände hinsichtlich ganz unterschiedlicher Aspekte durchforsten kann.

Durch die zunehmende Digitalisierung entstehen große Musikkollektionen, die neben Audio- und Videoaufnahmen auch symbolisch oder grafisch kodierte Notentexte enthalten. Ein Beispiel hierfür ist das multimediale Musikangebot des Carus-Verlag, der neben seinem Angebot von sorgfältig edierten Notenausgaben für mehr als 30,000 Chorwerke auch Referenzeinspielungen produziert und Videos für Unterrichts- und Übezwecke entwickelt. Allgemein gesprochen ist das Hauptziel des „Music Information Retrieval“ (MIR) die Entwicklung effizienter Such- und Navigationssysteme, die es dem Benutzer erlauben, komplexe Musikdatenbestände bezüglich unterschiedlicher musikrelevanter Aspekte zu durchsuchen. Während die textbasierte Suche nach Musik anhand von Komponistennamen, Liedtexten, Werkverzeichnisnummern oder dergleichen mit klassischen Datenbanktechniken möglich ist, stellt die inhaltsbasierte Suche in Musikdaten ohne das Zurückgreifen auf textuelle Metadaten ein schwieriges Problem dar.

Prof. Dr. Meinard Müller ist Professor am Lehrstuhl für Semantische Audiosignalverarbeitung an den International Audio Laboratories Erlangen.

Dr.-Ing. Frank Zalkow war Doktorand unter Prof. Dr. Meinard Müller und arbeitete mit diesem zusammen am Projekt „Automatisierte Methoden und Werkzeuge zur Analyse und Strukturierung von Chormusik“.

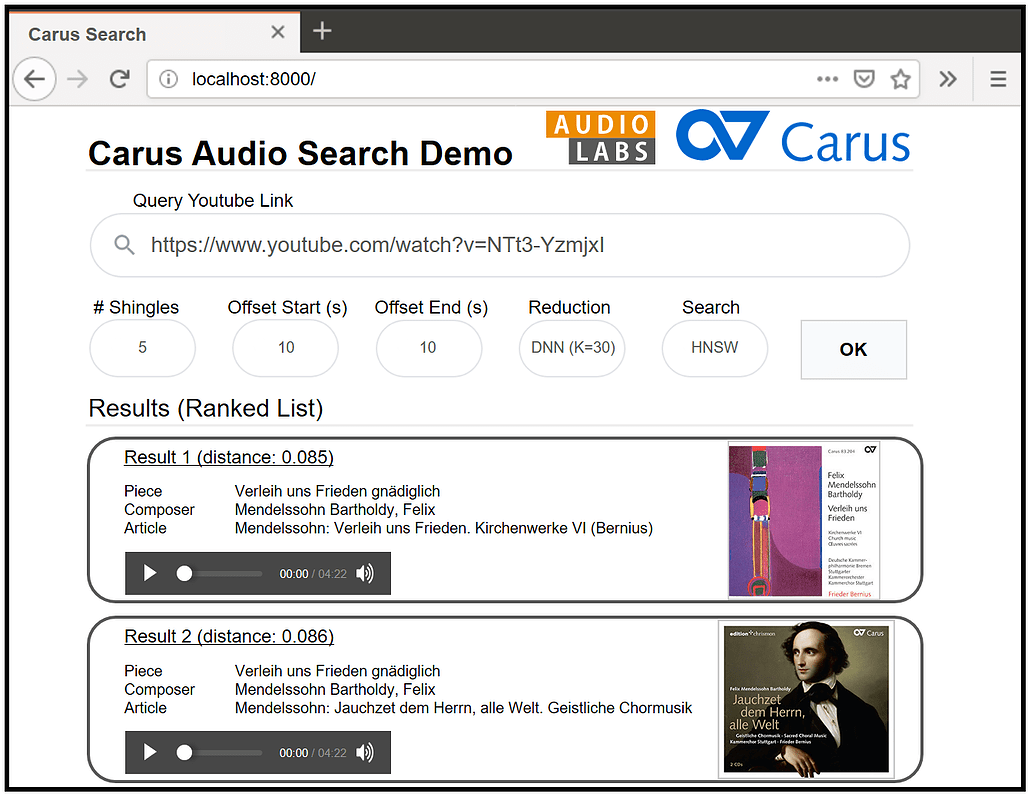

In dem gemeinsamen DFG-Projekt wurden Verfahren der inhaltsbasierten Suche entwickelt und auf Musikaufnahmen des Carus-Audiokatalogs angewendet. Hierfür hat der Carus-Verlag einen Großteil seines Audiokatalogs aufbereitet und für interne Experimente zur Verfügung gestellt. Der Datenbestand besteht aus 7115 Audiodateien und etwa 390 Stunden professionell produzierter Musik, hauptsächlich westlicher klassischer Vokalmusik. Für interne Demonstrationszwecke wurde von den Erlanger Forscherinnen und Forschern eine webbasierte Oberfläche zum Durchsuchen dieses Datensatzes entwickelt. Mithilfe dieses Demonstrators kann der Benutzer eine Anfrage in Form eines YouTube-Links zu einer beliebigen Interpretation eines Chorstücks stellen (z. B. gesungen von einem Laienchor). Die Aufgabe besteht dann darin, eine hochqualitative Aufnahme eines professionellen Chors desselben Musikstücks im Carus-Katalog zu identifizieren. Im dem Fall, dass ein YouTube-Video schlecht dokumentiert ist (also z. B. keine Metadaten über das Musikstück vorliegen), können inhaltsbasierte Verfahren, die nur auf die Musikaufnahmen selbst zum Abgleich zurückgreifen, zum Einsatz kommen. Da die Interpretation der Anfrage typischerweise nicht jener der Datenbank entspricht, ergeben sich bei der Suche verschiedene Herausforderungen: Es kann Unterschiede im Tempo, der Instrumentierung, der Struktur, der Tonlage und der Artikulation zwischen der Anfrage und den relevanten Datenbankdokumenten geben.

Webbasierte Oberfläche zum Durchsuchen des Carus-Datensatzes

Bei dem so skizzierten inhaltsbasierten Suchproblem wird ein kurzer, ca. 20-sekündiger Audioausschnitt der YouTube-Aufnahme als Grundlage für die Suchanfrage verwendet. Dieser wird durch Einsatz von Signalverarbeitungsmethoden in eine Merkmalsdarstellung transformiert, welche harmonische und melodische Eigenschaften des Audioinhalts erfasst. Diese Darstellung bezeichnen wir im Folgenden auch als Schindel (die Namensgebung wird gleich begründet). Weiterhin werden alle Aufnahmen der Datenbank in sich überlappende, jeweils 20-sekündige Audioausschnitte zerlegt, die dann ebenfalls in Schindeln transformiert werden. Anschaulich gesprochen werden dabei die Musikaufnahmen durch die Schindeln in etwa so abgedeckt, wie ein Hausdach durch Dachschindeln abgedeckt wird. Die eigentliche Suchanfrage wird nun rein auf Basis der Schindeln durchgeführt, wobei informatische Methoden der Nachbarschaftssuche zum Einsatz kommen. Im DFG-Projekt konnten dabei durch den Einsatz neuartiger Methoden der künstlichen Intelligenz und Graphen-basierter Indexierungsverfahren erheblich Verbesserungen hinsichtlich Laufzeit und Speicherbedarf erzielt werden. In umfangreichen Experimenten mit dem Carus-Audiokatalog konnte unter anderem gezeigt werden, dass die Bearbeitungszeit einer Suchanfrage um einen Faktor von mehr als 100 gegenüber herkömmlichen Suchverfahren reduziert werden konnte (weniger als 0,1 Millisekunden bei einer Datenbankgröße von mehr als 1,25 Millionen Schindeln). Neben der Implementation eines prototypischen Gesamtsystems zur inhaltsbasierten Suche im Carus-Audiokatalog konnten in diesem Kontext grundlegende wissenschaftliche Fortschritte zur Effizienzsteigerung erzielt werden. Diese Ergebnisse wurden in wissenschaftlichen Publikationen und in der Dissertation1 eines Projektmitarbeiters dargestellt.

Illustration der Schindeln für die Anfrage und den Audiokatalog

Das hier vorgestellte Verfahren zur inhaltsbasierten Suche stellt ein Beispiel für Grundlagenforschung im Bereich des MIR und der [automatisierten Musikverarbeitung2 dar. Aufgrund der Komplexität und Vielschichtigkeit von Musik benötigt man intelligente Methoden und Werkzeuge, die Beziehungen zwischen den verschiedenen Modalitäten (u. a. Notentext, Audio, Video), Versionen und Interpretationen eines Musikstücks erkennen und herstellen können. Durch die erfolgreiche Zusammenarbeit der Erlanger Ingenieurwissenschaften und dem Carus-Verlag als Projektpartner konnten hier nicht nur wesentliche Fortschritte in der Grundlagenforschung erzielt, sondern auch interdisziplinäre Querverbindungen zur Musikpädagogik und zu den Musikwissenschaften hergestellt werden.

Referenzen:

1Frank Zalkow: Learning Audio Representations for Cross-Version Retrieval of Western Classical Music. Dissertation, Friedrich-Alexander-Universität Erlangen-Nürnberg (FAU), Juni 2021.

2Meinard Müller: Fundamentals of Music Processing – Using Python and Jupyter Notebooks. 2. Auflage, Springer Verlag, ISBN: 978-3-030-69807-2, 2021. DOI: 10.1007/978-3-030-69808-9

Frank Zalkow, Julian Brandner, Meinard Müller: Efficient Retrieval of Music Recordings Using Graph-Based Index Structures. Signals 2(2): 336–352, 2021. DOI: 10.3390/signals2020021

Frank Zalkow, Meinard Müller: Learning Low-Dimensional Embeddings of Audio Shingles for Cross-Version Retrieval of Classical Music. Applied Sciences, 10(1), 2020. DOI: 10.3390/app10010019

Danksagung:

Wir bedanken uns bei den folgenden Personen (in alphabetischer Reihenfolge aufgeführt), die bei der Entwicklung der Suchfunktionalitäten und Aufarbeitung des Carus-Datensatzes mitgewirkt haben: Anna Bockisch, Julian Brandner, Iris Pfeiffer, Philipp Schlesinger, Angel Villar-Corrales, Christof Weiß.

Dein Kommentar

An Diskussion beteiligen?Hinterlassen Sie uns Ihren Kommentar!